Wenn ChatGPT zu dir sagt: „Ich bin hier, um dir zuzuhören“

Seit Ende 2022 ist das Thema Künstliche Intelligenz (KI) in der Gesellschaft angekommen. Mit dem Start des Programms „ChatGPT“ wurde deutlich, was diese Programme inzwischen können, und im Laufe des Jahres 2023 sehen wir, dass die Entwicklung dieser Technologien in atemberaubender Geschwindigkeit voranschreitet. Diese Technologien sind umwälzend, denn sie nehmen umfassend auf alle Lebens- und Arbeitsbereiche Einfluss und damit auch auf die Arbeitsbereiche des Sozialen.

Worüber sprechen wir, wenn wir über KI sprechen? Ein Programm wie ChatGPT wurde mit einer unvorstellbar großen Menge an Daten trainiert, um auf verschiedene Fragestellungen Antworten generieren zu können, die plausibel klingen und die es oft auch sind. Jede neu gestellte Frage hilft dem Programm dabei, besser zu werden. In Sekundenschnelle wird eine Antwort berechnet, die dabei auf die Daten zurückgreift, die dem Programm zur Verfügung stehen. Damit ist schon ein erstes Problem benannt: Programme der Künstlichen Intelligenz können nur mit den Daten arbeiten, die Teil des Programms sind, beziehungsweise mit den Daten, die im Internet frei zugänglich sind. So hatte ChatGPT bei der Veröffentlichung nur Daten bis Ende des Jahres 2021 und konnte somit keine Auskunft zu Vorgängen des Jahres 2022 geben.

Unweigerlich kommt es daher immer wieder zu Fehlinformationen oder einseitig geprägten Aussagen (Stichwort: Bias). Dabei ist wichtig zu wissen: Textgeneratoren wie ChatGPT sind keine Suchmaschinen, sie erstellen Antworten aufgrund von errechneten Wahrscheinlichkeiten. Das Kürzel GPT steht für „Generative Pretrained Transformer“, das bedeutet, dass diese Programme Ergebnisse neu zusammenstellen und kombinieren (Generative), basierend auf Trainingsdaten, die dem Programm vorher zugeführt wurden (Pretrained), und dass sie durch Wahrscheinlichkeitsrechnung das jeweils nächste meistwahrscheinliche Wort für einen Satz berechnen (Transformer).

Die Suche im Internet wird dialogisch

Neben dem sehr bekannten Programm ChatGPT (andere Textgeneratoren sind zum Beispiel Bard, Claude 2) gibt es Bildgeneratoren (Dall-E, Midjourney, Stable Diffusion), und die großen Suchmaschinen sind dabei, KI-Programme in den Suchvorgang zu integrieren. So kann man seit März 2023 in der Suchmaschine Bing bereits mit einer Version von ChatGPT kommunizieren, die einem die Suchergebnisse mit einer fertigen Antwort präsentiert. Interessant ist dabei, dass die Programme unterhalb der Antwort automatisch weitere Fragen vorschlagen, mit denen der Suchvorgang dann vertieft werden kann. Die Suche wird damit dialogisch, wir begeben uns in eine Art schriftliches Gespräch mit der Suchmaschine, ohne allerdings zu wissen, warum uns das Programm ausgerechnet diese oder jene Folgefrage für unsere Recherche vorgeschlagen hat. Diese Intransparenz der Algorithmen ist nicht erst seit KI ein Problem bei der Nutzung der digitalen Medien. Einen Überblick zu den derzeit verfügbaren KI-Programmen und ihren Möglichkeiten bietet zum Beispiel www.futurepedia.io.

Schaut man in die Medien- und Technikgeschichte, dann sieht man, dass mit dem Aufkommen einer neuen Technologie stets auch Skepsis, Kritik und manchmal auch Furcht einhergehen. Buchdruck, Telefon, Fernsehen, Internet – neue Medien sind oftmals disruptiv und werden kritisch beäugt. Bezogen auf die geschichtlichen Entwicklungen der KI erscheinen die Forschungsarbeiten des englischen Mathematikers Alan Turing zentral. In einem wegweisenden Aufsatz*1 aus dem Jahr 1950 beschreibt er, was Computer können beziehungsweise können werden, und dabei spricht er von einem „imitation game“, das heißt, Computer werden den Menschen in seinem Verhalten und in seiner Kommunikation imitieren, und zwar so gut, dass man nicht mehr unterscheiden kann, ob man mit einem Menschen oder ob man mit einer Maschine kommuniziert (Turing- Test). Wenige Jahre später zeigt Joseph Weizenbaum mit seinem Programm „Eliza“, dass Menschen bereit sind, auch mit sehr einfachen Chat-Programmen zu kommunizieren und ihnen sogar menschliche Eigenschaften zuzuschreiben (Anthropomorphisierung)*2. Von da an war es nur noch eine Frage der zur Verfügung stehenden Rechenleistung, bis die Programme unser Verhalten und unsere Kommunikation täuschend echt imitieren konnten. Diese Rechenleistung stellt heute kein Problem mehr dar, ist dabei jedoch zugleich sehr energie- und ressourcenintensiv.

Aktuell sehen wir bei den Entwicklungen, dass die Programme „multimodal“ werden beziehungsweise es bereits sind. Während die ersten Programme auf eine geschriebene Frage einen geschriebenen Text als Antwort ausgaben, kann man inzwischen aus einem Text ein Bild, aus einem Bild ein Musikstück oder auch aus einem Text ein Video generieren lassen, in dem ein Avatar in die Kamera spricht. Den Kombinationen sind hier keine Grenzen gesetzt. Dies bedeutet für die kommenden Wahlkämpfe auf europäischer oder US-amerikanischer Ebene übrigens auch, dass die Anzahl der perfekt gemachten Fake-News (Text, Bild, Ton und Video) stark zunehmen wird und damit die Beeinflussung von Stimmungen und Wählerverhalten. Keine leichte Zeit für die politische Bildung.

Verschiedene Arbeitsbereiche erleben einen Wandel

Auf der anderen Seite leisten diese Programme Erstaunliches: Sie verfassen einen Aufsatz oder einen Blogbeitrag, sie gliedern ein Seminar zu einem bestimmten Thema oder sie beantworten eine psychosoziale Anfrage in der Mailberatung. Die Ergebnisse können sich sehen lassen und überraschen durch ihre manchmal wirklich guten Formulierungen und natürlich durch die Schnelligkeit, mit der diese Antworten entstehen. Verschiedene Arbeitsbereiche erleben hier einen Wandel, was nicht zwangsläufig bedeutet, dass Jobs wegfallen werden, allerdings werden sich Arbeitsprozesse verändern, wenn zum Beispiel ein Programm von einer Konferenz automatisch eine Mitschrift anfertigt (und diese in beliebige Sprachen übersetzen kann), wenn Texte für die Öffentlichkeitsarbeit rasch und eloquent von einem Programm verfasst werden oder künstliche Telefonstimmen dazu verwendet werden, die menschliche Kundenhotline zu unterstützen oder gar zu ersetzen.

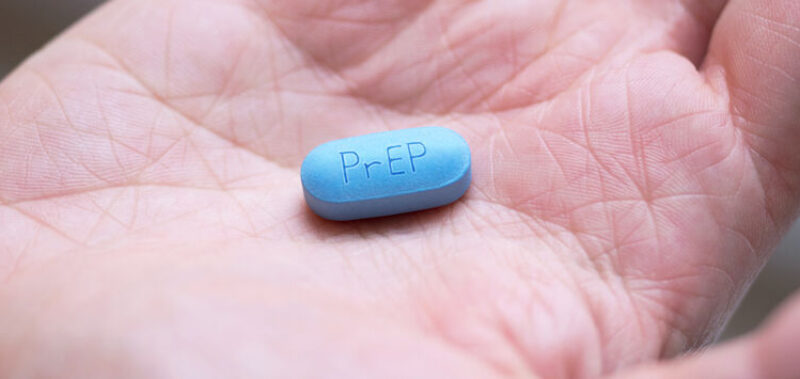

Schreibt man mit einem Programm wie ChatGPT über psychosoziale Themen, dann kann es einem passieren, dass das Programm zwar keine genaue Antwort auf die Beratungsanfrage hat, aber schreibt: „Ich bin hier, um dir zuzuhören!“ Das ist überraschend, denn einerseits schreibt das Programm von sich selbst in der Ich-Form und andererseits suggeriert es durch die Aussage, dass es hier sei, um zuzuhören, ein dialogisches Gesprächsangebot, welches es faktisch nicht ist und nicht sein kann. Denn KI-Programme „verstehen“ inhaltlich nicht, was wir ihnen schreiben, sie berechnen Wahrscheinlichkeiten und simulieren damit einen Dialog, der auf Seite der Ratsuchenden als Dialog mit einem realen Menschen erlebt und (miss-)verstanden werden kann. Diese Erfahrung machte Joseph Weizenbaum mit seinem einfachen Chat-Programm „Eliza“ in den späten 1960er-Jahren.*3 Seine Sekretärin vertraute dem Programm private Details an, obwohl sie wusste, dass es sich nur um ein simpel programmiertes Computerprogramm handelte.

Mit wem kommuniziere ich eigentlich?

Frank Engel schrieb am Beginn der Entwicklung der Onlineberatung, dass die „Beratung im Zeitalter ihrer technischen Reproduktion angekommen“*4 sei, und heute müssen wir uns aktuell an der Beantwortung der Frage beteiligen, ob Beratung nun im Zeitalter ihrer technischen Produktion angekommen ist.

Aus ethischer Sicht gibt es mit der weiten Verbreitung von KI-Programmen gleich mehrere kritische Aspekte zu beleuchten. Zunächst kann festgehalten werden, dass nicht transparent ist, mit welchen Daten diese Programme trainiert wurden. Wir wissen also nicht, warum das Programm so antwortet, wie es antwortet, und ob jemand einen bestimmten Zweck mit diesen Programmen verfolgt. »

Darüber hinaus muss gefragt werden, mit wem wir eigentlich kommunizieren, wenn wir mit einer KI kommunizieren, und wer für die Antworten und Handlungen eines Programms letztlich die Verantwortung trägt und haftet. Und wie immer, wenn es um digitale Kommunikation geht, müssen die Fragen des Datenschutzes sowie der Datensicherheit in den Fokus genommen werden. Was geschieht zum Beispiel mit den Daten, die eine KI von uns aufnimmt? Auf europäischer Ebene werden hier Gesetzesvorhaben auf den Weg gebracht, um KI-Anwendungen zu regulieren, diese Gesetze werden allerdings noch Jahre brauchen, bis sie auch auf nationaler Ebene ratifiziert sind.

Wer hat den Text geschrieben?

Dieser Text wurde von einem Menschen geschrieben, das müssen Sie, liebe Leser:innen, mir an dieser Stelle einfach glauben. Denn Sie haben keine Möglichkeit, herauszufinden, wer diesen Text geschrieben hat: eine Person oder ein Computerprogramm – das Imitation Game ist damit gewonnen. Wir werden diese Entwicklungen der Künstlichen Intelligenz nicht aufhalten können, aber im besten Fall können wir sie kritisch begleiten und genau abwägen, wo wir den Einsatz von KI-Systemen in den Arbeitsfeldern des Sozialen gutheißen und sinnvoll gestalten können und wo wir die Verwendung ablehnen, sei es aus Gründen des Datenschutzes oder weil unklar ist, wer im Zweifel die Verantwortung für das kommunikative Handeln einer KI trägt. Denn noch sind wir als menschliche Fachkräfte hier, um zuzuhören – und dies aus guten Gründen.

Anmerkungen

*1. Turing, A. M.: Computing machinery and intelligence. In: Mind, Volume LIX, Issue 236, 1950, pp. 433–460, https://doi. org/10.1093/mind/LIX.236.433

*2. Weizenbaum, J.: Die Macht der Computer und die Ohnmacht der Vernunft. Frankfurt: Suhrkamp Verlag, 1978.

*3. Weizenbaum, J.: a. a. O.

*4. Engel, F.: Beratung im Zeitalter ihrer technischen Reproduzierbarkeit. In: Nestmann, F. & Engel, F. (Hrsg.): Die Zukunft der Beratung. Tübingen: DGVT-Verlag, 2002.

Text: Stefan Kühne

Lehrbeauftragter für Digitale Soziale Arbeit, Herausgeber e-beratungsjournal. net, Wien

E-Mail: office@stefankuehne.net

Erstveröffentlichung in: „neue caritas“ https://www.caritas.de/neue-caritas/aktuelles

Wir danken für die Genehmigung zur Zweitveröffentlichung.

Diesen Beitrag teilen